皆さん、こんにちは。

本ブログでは、行動経済学を企業経営やビジネス戦略の現場で活用するための実践知をお届けしています。理論だけでなく、行動心理学・認知心理学・社会心理学といった周辺領域の知見も交えながら、組織の意思決定や環境設計への応用方法を考えていきます。

2025年を振り返ると、生成AIはもはや「一部の好きな人が触る新技術」ではなく、あらゆる業種・職種に静かに、しかし確実に入り込んだ1年だったように思います。ITmediaの年末総括記事でも、ChatGPT・Gemini・Copilotといった主要ツールの「どれが最強か」ではなく、「どう使い分けるか」がテーマになっていました。生成AIは、個人の作業効率化ツールから、チームや組織の業務フローに組み込まれる「前提インフラ」へと変わりつつあります。

一方で、日本経済新聞は「日本の経営者、18%がAI対応で『1年以内に人員削減』」という刺激的なタイトルの記事を掲載しました。AI導入を理由に人員構成を見直す動きが、いよいよ国内でも顕在化しつつあることがうかがえます。

同じく日本経済新聞は、「ロボ向け国産AI開発、経産省1兆円支援」という記事で、フィジカルAI向け国産基盤モデルに対して官民一体で1兆円規模の投資を行う構想を報じました。

さらにNewsPicksの「AIに『思考力』まで奪われていないか」では、生成AIに思考プロセスを丸ごと預けてしまう危うさに対し、強い警鐘が鳴らされています。(出典:[3])

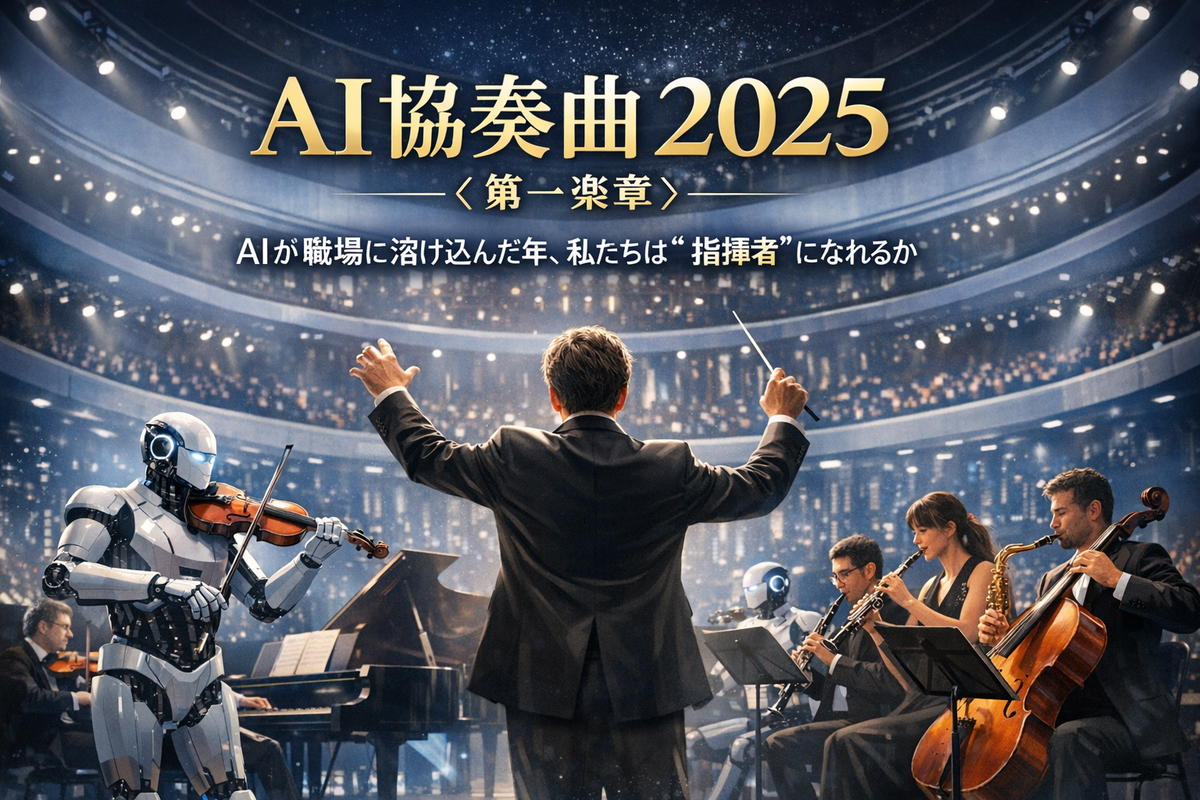

政策、企業、個人――それぞれが異なるリズムで動きながら、AIという一つのテーマの周りに集まってきた1年だった。その印象から、私は2025年を「AI協奏曲の年」と捉えてみたいと思います。

そこで今回は、これまで本ブログで取り上げてきたAI関連記事(「AIと共存する未来:行動経済学で考えるシンギュラリティへの備え」「生成AIが変える検索行動:ビジネスに必要な“新・情報リテラシー”」「AIウオッシュの危険性」「『ズルいAI』にどう立ち向かうか」など)も参照しながら、2025年のAI×ビジネスを行動経済学の観点から総括してみます。

behavioral-economics.hatenablog.com

明日の記事では、AGI(汎用人工知能)やASI(超人工知能)、そしてニューロモルフィック技術など「次の楽章」が描く2026年の展望について言及していきたいと思っています。本日は、その前段として、2025年という協奏曲の第一幕を丁寧に振り返ってみたいと思います。

本稿(第一楽章)で扱う論点(3点)

- 職場で進む「AIの使い分け」定着と、意思決定プロセスの変化

- 雇用・人員構成を揺さぶる“経営側の不安”と、組織に生まれる行動変容

- 国策としてのフィジカルAI投資が生む期待と過信、そして『指揮者』を取り戻す条件

「最強ツール探し」から「使い分けの設計」へ ― AIが職場に溶け込んだ一年

2025年のビジネス現場では、「どの生成AIが一番賢いか」という議論から、「目的に応じてどう組み合わせるか」という設計の話へと、焦点が移っていきました。ITmediaの年末総括記事が示すように、ChatGPT・Gemini・Copilotといったツールは、それぞれ得意分野が異なる「楽器」として扱われるようになり、私たちはそのオーケストレーションを日々の仕事の中で試行錯誤してきました。本章では、この「使い分け」の定着が、人間の意思決定と行動にどのような変化をもたらしたのかを整理してみます。

ITmediaの記事では、2025年の生成AI進化を「Deep Research(調べものの起点がAIに移った)」「マルチモーダル対応」「エージェント機能の実用化」など、いくつかの機能進化に整理していました。私自身も、リサーチの入り口としてブラウザ検索ではなく生成AIを開く頻度が、明らかに増えた一年でした。

本ブログでも、「生成AIが変える検索行動:ビジネスに必要な“新・情報リテラシー”」で、Google検索の減速とAI検索へのシフトを取り上げました。そこでは、AIが返してくれるのは「ページ一覧」ではなく、「それなりにまとまった『答えらしきもの』」であり、そのことが私たちの情報収集プロセスを大きく変えていると指摘しました。

behavioral-economics.hatenablog.com

行動経済学的に見ると、ここには少なくとも3つの変化があります。

変化① 探索コストが消えた:検索のデフォルトがAIへ

以前は、複数のページを開いて比較しなければ得られなかった情報が、1回のプロンプトで統合された形で提示されるようになりました。これは、選択のための「検索コスト」「比較コスト」を大きく下げます。その結果、「とりあえずAIに聞いてみる」という選択が、意思決定のデフォルトになりやすくなります(デフォルト効果)。

変化② 思考プロセスの外部化:論点整理まで“外注”される

生成AIは、単なる情報の要約ではなく、「論点の整理」「構成案の叩き台」「メール文面の初稿」まで、一気に提示してくれます。本来であれば人間が頭の中で行っていた「問題の切り分け」や「論理の組み立て」の一部が、外部ツールに移管されていく流れです。これは、認知心理学でいう「認知的オフローディング(cognitive offloading)」の典型例と言えます。

変化③ ツール選択のクセ:現状維持バイアスが“固定編成”を生む

ChatGPTかGeminiかCopilotか――本来は、タスク内容に応じて最適な組み合わせを考えるべきですが、現実には「いつも使っているツール」「最初に慣れたツール」に偏りがちです。これは、現状維持バイアスやハロー効果(最初の好印象が評価全体を支配する傾向)が働いていると考えられます。

本ブログでは、AIエージェントをテーマにした記事や、「ズルいAI」との付き合い方を論じた記事でも、AIを「有能なインターン」や「提案マシン」として位置づけ、人間側が最終判断と責任を持つ重要性を繰り返し指摘してきました。

behavioral-economics.hatenablog.com

2025年は、ツール側の機能進化だけでなく、私たちの側の「AIとの距離感」「どこまで任せ、どこから自分で考えるか」という行動ルールが、ようやく形になり始めた一年だったと言えるでしょう。

AIと人員削減のパラドックス ― 「仕事がなくなる」より「仕事の中身が変わる」一年

2025年後半、日本経済新聞が報じた「日本の経営者、18%がAI対応で『1年以内に人員削減』」という記事は、多くの人の不安を刺激しました。一方で、同じ調査では「3年後には総従業員数は増える」と答えた企業が9割を占めています。このギャップは、行動経済学的にどのように理解できるのでしょうか。本章では、AIと雇用をめぐる「恐怖」と「期待」のねじれを、2025年の動きと自分の過去記事を踏まえて整理します。

KPMGが世界11カ国・1350人の経営者を対象に実施した調査によると、「今後1年内にAI普及に伴って人員削減を計画している」と答えた経営者は世界全体で15%、日本では18%でした。特に消費財メーカーや小売り、医療分野などでその割合が高い一方で、3年後の総従業員数については「増加する」と答えた企業が9割を占めています。

この結果は、一見すると矛盾しているように見えますが、「職種ごとの需給の組み替え」として捉えれば理解しやすくなります。事務職の求人広告件数が大きく減少している一方で、AIリテラシーやデータ活用スキルを持つ人材の需要は高まっている。つまり、「AIが仕事を奪う」というより、「AIが仕事の中身と求められる能力を変える」フェーズに入ったと言えるでしょう。

本ブログでも「黒字リストラとAI時代のキャリア防衛戦略」や「AI時代に“残る仕事”が選ばれない理由:エッセンシャルワーカーのパラドックス」で、このねじれを扱いました。前者では、「業績は黒字なのに人員削減が行われる背景」に、株主圧力やAI投資のための原資確保といった要因だけでなく、「周囲と同じように合理化しないと不安になる」という同調バイアスが働いている可能性を指摘しました。後者では、「社会に不可欠な仕事ほど、待遇や心理的報酬が必ずしも高くない」というパラドックスを、エッセンシャルワーカーの事例から検討しました。

行動経済学の観点から見ると、ここでは次の3つのバイアスが重要です。

バイアス① 損失回避:『人員削減』の一語が恐怖を増幅する

企業側は、AI導入の投資回収圧力の中で、「コスト削減」というわかりやすい形で成果を示したくなります。このとき、「人件費削減」という数字に表れやすい効果に過度に重心が置かれがちです。従業員側も、「今の仕事がなくなる」という損失イメージに強く反応し、「仕事の中身が変わる」「新しいスキルを獲得する」というポジティブな側面を過小評価しがちです。

バイアス② フレーミング:『削減』か『再配置』かで物語が変わる

同じ施策でも、「AIによる合理化で人員削減」と報じられるのか、「AIで生産性を高め、成長分野に人を再配置」と説明されるのかで、受け取り方は大きく変わります。実際には、新規採用を絞りつつじわじわと人員構成を変える「静かな置き換え」も多いはずですが、「人員削減」という言葉だけが切り取られると、社会全体の不安が必要以上に増幅されます。

バイアス③ 現在志向:長期の職務再設計が後回しになる

3年後の人員増加を想定していても、当面1年のコスト削減効果の方が意思決定に強く効いてしまう。その結果、本来であれば再教育や配置転換に時間をかけるべきところを、「まず削減ありき」で動いてしまうリスクがあります。

2025年は、「AIと雇用」をめぐる議論が、ようやく「仕事はなくなるのか/なくならないのか」という二者択一から、「仕事の中身とスキル構成がどう変わるのか」というより具体的な問いに移ってきた年でもありました。2026年以降は、企業側がその変化をどれだけ戦略的に設計できるか、そして個人がどれだけ主体的にキャリアのポートフォリオを組み替えられるかが、一段と問われてくるはずです。

「フィジカルAI」と1兆円投資 ― 国家レベルのナッジとしての産業政策

2025年の後半、国内AI政策の文脈で象徴的だったのが、「ロボ向け国産AI開発、経産省1兆円支援」というニュースでした。フィジカルAI向けの基盤モデルに、官民で5年間にわたり1兆円規模を投じる構想は、日本として「どの分野で勝負するのか」を示すメッセージでもあります。本章では、この政策を行動経済学的に見ると何が見えてくるのかを考えます。

記事によると、ソフトバンクなど十数社が出資する新会社構想のもと、ロボットや自動運転車などを制御するフィジカルAI向けに、国産の汎用基盤モデルを開発する計画が進んでいます。パラメーター数は国内最大級の1兆規模をめざし、低消費電力で動作するモデルの開発に対して、GX経済移行債を原資に支援する方針が示されました。

背景には、日本が産業用ロボットの供給大国である一方で、AI(とりわけ基盤モデルや半導体・クラウド)では米中が先行しやすいという“強みの非対称性”があります。国際ロボット連盟(IFR)の整理では、日本は世界の産業用ロボット生産の約38%を占める主要国であり、「ロボットのハードは強いが、AIソフトで米中に先行される」という危機感が産業政策の背中を押している、と読むことができます。

行動経済学のフレームで見ると、この政策は「国家レベルのナッジ」として捉えることができます。

ナッジ① 方向づけ:『この方向に追い風』という国家シグナル

民間企業にとって、AI投資の選択肢は無数にあります。大規模言語モデルに資源を投じるのか、特定業種向けソリューションに絞るのか、それとも物理世界と結びついたフィジカルAIに重点を置くのか。ここで、政府が1兆円規模の支援方針を打ち出すことは、「この方向に行くと追い風が吹きますよ」という強いシグナルになります。補助金や税制優遇策は、企業の意思決定における「フレーミング」を変える典型的なナッジです。

ナッジ② 国内データ:参照点を“国内標準”に固定する

記事でも、製造現場に蓄積された産業データが海外勢に吸い取られることへの懸念が指摘されていました。国産基盤モデルを整備し、その上に応用サービスを載せていくことで、「データは国内にとどめる」という暗黙のルールを形成しようとしているとも読めます。これは、行動経済学でいう「参照点」の設計――「データは国内で活用するのが当たり前」という基準を社会に埋め込もうとする試みとみなせます。

ナッジ③ AIウオッシュ:便乗AIを増やすのか、減らすのか

本ブログでは、「AIウオッシュの危険性:企業が取るべき信頼戦略」で、実態を伴わないAI活用の誇張が、いかに企業の信頼を損ないうるかを論じました。官民一体の大型投資が始まると、「国策AI」「フィジカルAI関連」を名乗る企業が増え、AIウオッシュのリスクも同時に高まります。補助金獲得や株価対策を目的とした「便乗AI」をいかに排除するかは、2026年以降の大きな課題になるでしょう。([ビジネス×行動経済学][10])

一方で、2025年はウォルマートのリスキリング事例などを通じて、「AI時代に人間の役割をどう再定義するか」という問いも浮かび上がりました。フィジカルAIが清掃・警備・物流などの現場で実装されていくとき、日本企業が「人間に残す仕事」をどのように設計するのか――ここでも行動経済学的な視点が重要になります。

behavioral-economics.hatenablog.com

AIは思考力をむしばむのか ― 「丸投げ」と「共奏」の境界線

NewsPicksの「AIに『思考力』まで奪われていないか」という記事は、2025年の生成AIブームの「負の側面」に光を当てるものでした。

宿題や業務を丸ごとAIに投げてしまうと、人間は「問題理解」「情報収集」「論点整理」といったプロセスそのものを経験しなくなってしまう。これは単なる感覚的な不安ではなく、行動経済学・認知心理学の研究とも整合的な問題提起です。本章では、そのリスクと対処法を整理します。

記事では、戦略論の第一人者である三谷宏治氏が、「生成AIは問題理解から解答作成までのプロセスを丸ごと代替してしまう」と述べています。宿題の問いをそのまま入力すれば、AIが勝手に調べ、構成し、文字数指定まで守ってくれる。そこに至る人間側の思考プロセスがすっぽり抜けてしまうことが、本質的な問題だという指摘でした。

この懸念は、行動経済学・認知科学の実験結果とも響き合います。例えば「To Trust or to Think」という研究では、AIの提案に対して人が過度に依存してしまう「オートメーション・バイアス」が観察されており、AIの説明を丁寧に読ませるだけでは過信を防げないことが示されています。むしろ、「自分の仮説を書かせる」「AIの提案に反論点を必ず挙げさせる」といった「認知的強制(cognitive forcing)」を設計することで、初めて過信が抑制されることが報告されています。

【実務テンプレ】AIの助言を鵜呑みにしないための3点チェック

- 反証の義務:まず『この結論が間違うとしたら?』をAIに先に質問する(反証プロンプト)

- 根拠の棚卸し:根拠を“データ/経験則/推測”に分類し、推測は別扱いにする

- 意思決定の停止線:重要判断は『別ソース確認』または『第三者レビュー』を必須工程にする

また、「Corrupted by Algorithms?」という研究では、AIが提示する「不正を促す助言」が、人間の不正行動を増やしてしまうことが示されました。しかも、「これはAIからの助言です」と透明性を高めても、行動はあまり変わらない。AIを「客観的で中立な存在」とみなしてしまうバイアスが働き、批判的思考が停止してしまうことがうかがえます。

本ブログでも、「生成AIが変える検索行動」や「信じてしまうのはなぜか?:『それっぽい嘘』とAI過信の心理設計」で、AIによる「もっともらしい誤情報(ハルシネーション)」に人がだまされやすい構造を取り上げてきました。特に、以下のようなバイアスが組み合わさることで、AI過信が生まれます。

- 権威バイアス:

「高度なモデル」「大手企業が提供している」というラベルがつくだけで、答えを過大評価してしまう。 - 一貫性バイアス:

普段からAIの回答に助けられていると、たまたま間違った回答に出会っても、「何か自分の方が読み違えているのでは」と考えがちになる。 - 努力回避の傾向:

自分で調べたり考えたりするコストを避けたいという、ごく人間らしい傾向が、AIの利便性によって増幅される。

重要なのは、「AIを使うかどうか」ではなく、「どのプロセスをAIに任せ、どのプロセスは人間のまま残すのか」を意識的に設計することです。例えば、

- 問題理解と論点整理は人間が行い、情報収集や草稿生成をAIに任せる

- AIが出した案に対して、「あえて反論する時間」をスケジュールに組み込む

- 若手育成では、あえて「AI禁止の演習」と「AI前提の演習」をセットで行う

といった運用ルールが考えられます。

2025年は、「AIに思考力を奪われていないか?」という問いが、単なる感情的な不安から、具体的な設計課題として認識され始めた年でもありました。2026年以降は、「AIとの協奏」を続けながら、自分自身の思考筋力をどう鍛え直すかが、個人・組織ともに問われていくはずです。

AIウオッシュ、AIエージェント、AI検索 ― 情報環境としての「AI協奏曲」

2025年は、AIそのもの以上に、「AIをどう語るか」が大きな意味を持った一年でもありました。AIウオッシュ的な誇張、AIエージェントへの過剰な期待、AI検索の急速な普及――こうした「AIをめぐる言論空間の変化」が、人々の行動に影響を与えました。本章では、本ブログで取り上げてきたAI関連記事を振り返りながら、この情報環境の変化を整理します。

behavioral-economics.hatenablog.com

まず、「AIウオッシュの危険性:企業が取るべき信頼戦略」では、実際にはAIをほとんど使っていないにもかかわらず、「AI搭載」「AIで最適化」といったラベルだけを前面に出す事例を紹介しました。これは「グリーンウオッシュ」と同じ構図であり、「AIを使っている企業は先進的である」という社会的証明バイアスを利用したものです。

次に、「生成AIと言論空間の未来:健全か混乱か」では、生成AIが「情報を消費する側」だけでなく、「情報を供給する側」としても急速に存在感を増している現状を検証しました。ブログやSNS、ニュースコメント欄において、AIが自動生成したコンテンツが洪水のように増えることで、「何が人間の声なのか」「何がオリジナルなのか」が見えにくくなりつつあります。

さらに、「ビジネスに革新をもたらすAIエージェント:その可能性とリスク管理の重要性」では、AIエージェントが「自律的にタスクを実行してくれる存在」として注目される一方で、誤作動や誤判断が発生したときの責任の所在や、エージェントに過度に任せすぎることによる「責任感の希薄化」というリスクを指摘しました。ここにも、行動経済学でいう「責任の拡散(diffusion of responsibility)」が顔をのぞかせます。

そして、「生成AIが変える検索行動」では、AI検索が「とりあえずググる」という行動を「とりあえずAIに聞く」に置き換え始めていることを取り上げました。検索結果のリストから自分で情報を選び取るのではなく、AIがあらかじめ要約してくれた「一つの答え」を受け取る。この構造は、フレーミング効果やアンカリング効果を通じて、人々の判断に影響を与えます。

こうした動きをまとめると、2025年の「AI言論空間」は、次のような特徴を持っていたと言えます。

- 「AIを使っている」と言うこと自体が、レピュテーション上のシグナルになった

- AI発の情報と人間発の情報が混在し、出どころの判別が難しくなった

- AIが提示する「それっぽい答え」が、人々の判断の出発点(アンカー)になりやすくなった

だからこそ、企業や個人には、「AIをどう活用するか」だけでなく、「AIについてどう語るか」「AIが作った情報をどう扱うか」という二重のリテラシーが求められるようになっています。AI協奏曲の中で、「どのパートの音を信頼し、どのパートには慎重になるべきか」を見極める耳を鍛えることが、2025年の大きな宿題として浮かび上がったと言えるでしょう。

2025年AI協奏曲の構図 ― 個人・企業・国家が奏でた三重奏

ここまで見てきたように、2025年のAIは「一つの技術トレンド」というより、「個人・企業・国家」という三つのレイヤーが、それぞれの論理で動きながら絡み合う協奏曲でした。本章では、その三重奏を簡潔に整理し、2026年への橋渡しをしてみます。

個人:第2の頭脳化と“丸投げリスク”

個人レベルでは、生成AIが「第2の頭脳」として日常業務に深く入り込んだ一年でした。プロンプト設計やツールの使い分けが、「できるビジネスパーソン」の新しい条件になりつつあります。一方で、NewsPicksの記事が指摘するように、「思考プロセスを丸ごとAIに丸投げする」危うさも顕在化しました。AIに頼るほど、問いを立てる力や、論理の筋を自分で確かめる力が問われる――この逆説が見えてきたのが2025年だったと言えるでしょう。

企業:雇用は減るのではなく“ポートフォリオが組み替わる”

企業レベルでは、「AI投資」と「人員構成の見直し」がセットで語られ始めました。黒字リストラやホワイトカラーの採用抑制といった動きに、KPMG調査の記事が追い打ちをかけました。一方で、AIを活用して新規事業や高付加価値サービスを生み出せる企業にとっては、AIはむしろ雇用拡大のドライバーにもなりうる。その意味で、AIは「雇用を減らす技術」でも「増やす技術」でもなく、「雇用ポートフォリオを組み替える技術」として位置づけ直すべき段階に来ています。

国家:投資は“産業の参照点”を作る

国家レベルでは、フィジカルAIへの1兆円投資や、データセンター・電力インフラへの支援策などを通じて、「どの分野で主導権を取りに行くのか」がより明確になってきました。ここには、純粋な技術戦略だけでなく、「国内産業をどう守るか」「どのデータを国内にとどめるか」といった地政学的な意図も織り込まれています。([日本経済新聞][2])

この三つのレイヤーの動きには、共通して次のような構図が見て取れます。

共通構図:ストーリーとバイアスが意思決定を支配する

- 技術そのものよりも、「技術をどう物語るか(ストーリーテリング)」が意思決定に大きな影響を与える

- 行動経済学で知られる様々なバイアス(損失回避、現状維持バイアス、社会的証明、オートメーション・バイアスなど)が、AIという新しい文脈で再現されている

- 「AI vs 人間」という対立構図ではなく、「AI+人間+制度」という三つ巴の設計問題として捉え直す必要がある

2025年は、AIというテーマのもとで、個人・企業・国家がそれぞれのパートを演奏し始めた「協奏曲の第一楽章」だった――私はそう感じています。

まとめ 2025年AI協奏曲の終わりと、次の楽章への準備

最後に、2025年のAI×ビジネスを振り返りながら、2026年に向けて私たちが押さえておきたいポイントを、行動経済学的な観点から整理しておきます。

① 「とりあえずAIに聞く」を前提にした上で、「どこから先は自分で考えるか」を決める

生成AIの利用は、もはや多くのビジネスパーソンにとってデフォルトになりました。この流れを逆行させる必要はありません。ただし、「問題設定」や「最終判断」といった、価値観や責任が色濃く反映される部分までAIに委ねてしまうと、思考力の空洞化が起こります。自分の仕事のプロセスを棚卸しし、「どこまでをAIに任せても良いのか」「どこから先は自分の頭で考えるのか」を明文化しておくことが、2026年に向けた第一歩になります。

② AI投資を「コスト削減ストーリー」だけで語らない

AI導入に伴う人員構成の見直しは避けて通れませんが、「人件費削減」という短期的なストーリーだけで語ると、損失回避バイアスが従業員の抵抗感を増幅させます。「どの仕事をAIに引き継ぎ、どの仕事を人間に再設計するのか」「どんなスキルを新たに獲得してもらうのか」といったポジティブな物語を、セットで提示することが重要です。AIを「リストラの口実」にするのか、「職務再設計のドライバー」にするのかで、社員の行動は大きく変わります。

③ 「国策AI」「フィジカルAI」の物語に飲み込まれない

官民一体の大型投資は、確かに魅力的なチャンスです。しかし、「国策だから」「補助金が出るから」という理由だけでプロジェクトを進めると、AIウオッシュ的な動きに巻き込まれやすくなります。自社の強みや顧客価値とどう結びつくのかを起点に考え、「AIありき」ではなく「事業戦略ありき」で技術選択を行うことが、2026年以降の分かれ目になるでしょう。

④ 自分自身のバイアスを前提にしたAIリテラシーを身につける

AIリテラシーというと、「プロンプトの書き方」や「ツールの機能理解」が注目されがちです。しかし、本当に重要なのは、「自分がどんな場面でAIを過信しやすいのか」「どんなときに楽をしたくなり、思考を放棄してしまうのか」といった「自己のバイアス理解」です。行動経済学で明らかにされてきた様々なバイアスを、自分の仕事の場面に当てはめてみることが、AI時代の新しいリテラシーの土台になります。

⑤ 「協奏曲」の設計者としての視点を持つ

AI協奏曲の中で、私たちは単なる「聴衆」ではなく、「演奏者」であり、場合によっては「指揮者」でもあります。自分のチームや組織において、AI・人間・制度がどのように組み合わさっているのかを俯瞰し、どのパートの音量を上げ、どのパートには休符を与えるのか――そんな視点で設計していくことが、2026年以降の競争力を左右していくでしょう。

2025年という一年は、AIと人間、そして制度が初めて本格的に「同じステージに立った」協奏曲の第一楽章でした。まだ音程のずれも多く、ハーモニーというには程遠い場面もありましたが、それでも「一緒に演奏する」という選択肢が現実味を帯びてきたこと自体が、大きな一歩だったと感じています。

明日、2026年初回の記事では、ここで振り返った協奏曲を土台に、AGIやASI、ニューロモルフィック技術、そして「GPUに依存しない高性能LLM」といった次の技術トピックが、この楽譜を書き換えるのか、それとも新たな楽章を付け加えるのかを考えていきたいと思います。引き続き、「行動経済学×ビジネス×AI」というテーマで、一緒にこの協奏曲の続きを眺めていければ幸いです。

今回はここまでとします。最後までお読みいただき、ありがとうございました。

2025年の一年間、本ブログにお付き合いくださった皆さまにも、心より感謝申し上げます。お寄せいただいたご意見や感想が、執筆を続ける大きな励みになりました。

明日公開予定の第2弾記事「AI協奏曲2026〈第二楽章〉」も、ぜひお楽しみください。

どうぞ良いお年をお迎えください。